勉強会を開催しました 「OnsenUI + AngularJS + CloudEndpointsで作るSPA 地雷処理の巻」

...こんにちは、エンジニアのsaekiです。

2016年5月20日、弊社で初めて外部向けの勉強会を開催しましたのでその様子をご報告します。

経緯

弊社では、会社として社外のエンジニアとの交流や知見共有の必要性を日々感じており、社内のエンジニアから外部向けの勉強会を開きたいという声が上がっていました。

そこでエンジニアが中心となり、初めて外部に向けた勉強会を開催することとなりました。

発表内容

「OnsenUI + AngularJS + CloudEndpointsで作るSPA 地雷処理の巻」

弊社エンジニアの古山が登壇しました

懇親会の様子

テーブルを囲ってみんなで乾杯

ビールとソフトドリンク、ハンバーガーが振舞われました

ハンバーガーおいしそうですね

おわりに

参加していただいた方からは、 「Onsen UIとCloudendpointを使ってみたくなった」 「他のプロジェクトの話も聞いてみたい」 「懇親会の雰囲気がとても良かった」 「これからもISAOの勉強会には参加していきたい」 などのフィードバックをいただき、参加していただいた方にとってご満足いただける内容になったのかなと思います。

弊社は今後も社外へ向けた勉強会を開催していく予定ですので、 これからもぜひご参加ください。

最後になりますが、ISAOでは一緒にサービスを作ってくれるエンジニアを絶賛募集中です。 もし少しでもご興味を持っていただけましたら気軽に弊社に遊びにいらしてください。

新卒採用担当のヒトリゴト〜私はお祈りメールが嫌いです〜

...皆さん、こんにちは!人事の市橋です。

本日6月1日、大手企業の内定解禁日ですね。 今日から数日、悲喜こもごも色々あると思います。

お祈りメール

昨年「オワハラ(就活終われハラスメント)」という言葉が話題になりました。 いわゆる就活ワードですね。 もう一つ大きな就活ワードがあります。 それが「お祈りメール」です。

いわゆる企業からの不採用通知の俗称。 メールの末尾に「今後の活躍をお祈り申し上げます」といった感じで締められていることが多いので、そう呼んでるみたいです。

いわゆる企業からの不採用通知の俗称。 メールの末尾に「今後の活躍をお祈り申し上げます」といった感じで締められていることが多いので、そう呼んでるみたいです。自分が学生のときはこんな言い方しませんでしたが、いつの間に!?という感じです。

企業と学生

さて、企業がなぜお祈りメールを送るのか。

- 時間の短縮

- 何も考えずに送れるので楽

などの理由があると思います。

では、逆にお祈りメールを受け取る学生はどのように感じているのだろう。

世間には色々な声があるようですが、総じてネガティブですね。

- 悲しい気持ちになる

- 心がない

- どの会社も同じで怒りすらこみ上げる

ちなみに最近はメールすら送らない「サイレントお祈り」も結構あるとか。

ISAOの場合

さて、ISAOの新卒採用デッドラインは5月31日。 色々悩んだけど、今回縁がなかった学生へお祈りメールを・・・

いや、ちょっと待て。何か違う。

いや、ちょっと待て。何か違う。 今まで遠くから何度も足を運んでもらい、何度も話をした結果、 「お祈り申し上げます」ってメールで終わるのは何かおかしい。

今まで遠くから何度も足を運んでもらい、何度も話をした結果、 「お祈り申し上げます」ってメールで終わるのは何かおかしい。 確かにメールは何も考えず、一方的に送ることができるので送る側は楽かもしれない。 ただ、やっぱりこんなときは、しっかりと電話で気持ちを伝えたい!

確かにメールは何も考えず、一方的に送ることができるので送る側は楽かもしれない。 ただ、やっぱりこんなときは、しっかりと電話で気持ちを伝えたい! 私は「お祈りメール」が嫌いです。

私は「お祈りメール」が嫌いです。ISAOは最後までオープンに、学生と腹を割って話をします。 昨日も全員と電話でコミュニケーションをとりました。

結果、ISAOには入社しなかったけど、その後もSNSで繋がって、定期的に連絡を取り合うなど良い関係を築いている方もいます。

会社それぞれのスタンスはあるかもしれませんが、ISAOは今後も世界のシゴトを楽しくするビジョナリーカンパニーを目指し、 既成概念をぶっ飛ばしていきたいです。

仕事は成果!恒常的長時間労働は悪!

...日本の働きかたは効率が悪い!?

先日、JB Pressの記事にこんなのがありました。

だらだらと残業する社員には「マイナス残業代」だ/効率が悪い社員ほど出世していくのが日本の会社

http://jbpress.ismedia.jp/articles/-/46523最近、機会があれば周りの人には話すようにしているのですが 残業して成果を出そうとするのは、間違っている可能性が高いことが多いです。

僕たちISAOはインターネットのサービスを仕事としていますので、 トラブルの時など『いざ!』というときは、長い時間張り付いて成果を出すことを要求される宿命があることは否定できません。

ただ『いつも長時間労働して成果を出す』というのは、やはり何かおかしい。

仕事の仕方が間違っているか、そもそも自分が任された仕事に対して、実力が足りていないか。

何か間違っています。

労務的な問題は大きく、最近これは社会的に取り上げられているのですが、 もっと根本的に『本当に生産性の高い仕事をしているのか』という観点で見ても多くの場合は問題がありそうな気がします。

定時に帰る!

高度成長期の日本は、お父さんが家のことを顧みずに働いて、お母さんが家事を完全にカバーする働きかたが標準でした。

しかし、現代では共働きは当たり前ですし、育児だけでなく介護を仕事と両立して働かなくてはならない人が増えてきました。

いまを生きる僕たちの働きかたも、いまの時代にあったものにしていかなくてはなりません。

以前ISAOのエンジニアが、強い意志で定時に帰るという記事をQiitaで書いたのですが、 その中で彼は、「本当に集中してゾーンに入れる時間は一日3~4時間位」と言っています。

まさに喝破していると思いました。

成果を評価する

冒頭のJB Pressの記事にもありますが、

短時間で成果を出している人 < 残業しまくって成果が乏しい人

という評価を会社がしてしまうと、将来にわたって間違ったメッセージを与えてしまう結果になると考えています。

もちろん、心情的には『あいつ、頑張ってるからな・・・』という部分はありますが、 ISAOでは決して成果が乏しい人を評価はしないことにしています。

新しい組織のカタチ

僕らは、バリフラットという、新しい組織のカタチにチャレンジしていますが、 こういった成果や評価に関しての考え方も、旧来型の日本の悪しき伝統を打ち破っていきたいと思っています。

では、定時間である一日7〜8時間どうやって過ごすのか。

これは、また別の機会に書きたいと思います。

Microsoft Innovation Dayでスタートアップを応援します!

...Microsoft Innovation Day 2016、いよいよ開催です

今年もこの季節がやって参りました。 明日4/23(土)に開催される「Microsoft Innovation Day」に、ISAOは「BizSpark Tech Partner」としてお手伝いいたします!

Microsoft Innovation Day とは

公式サイト: http://ms-innovation-day.jp/

日本マイクロソフトさまの主催するイノベーション創造のイベントで、具体的には「Microsoft Innovation Award 2016」のファイナルピッチと、「Imagine Cup 2016」の日本代表選考会を軸に、スタートアップや学生、アクセラレーターなどなど、イノベーション創造に関わる人たちが集うイベントです。

Microsoft Innovation Award 2016

公式サイト: https://www.microsoft.com/ja-jp/ventures/mia/

- 「テクノロジーによるイノベーション」をキーワードとした、主にスタートアップ向けのアワード。

- 今年で9回目を迎えるそうで、ISAOでは去年からご支援しています。

- 明日のイベントでは、アワードのファイナルピッチが行われます。今年は総勢16のプロダクトが登壇するようです。

Imagine Cup 日本予選大会

公式サイト: https://www.microsoft.com/ja-jp/education/imagine-cup.aspx

- 世界最大の学生向けITコンテスト。

- 今年で14回目になるそうで、会場では日本予選大会ファイナルピッチが行われます。

- 「ゲーム」「イノベーション」「ワールドシチズンシップ」の3部門それぞれに3チームずつのピッチが行われ、各部門の代表が世界大会へと進みます。

- 今年のbuildに参加した際に、U.S部門のアワード受賞者によるプレゼンテーションイベントを見る機会がありました。こちらのレポートも併せてどうぞ!: https://blog.colorkrew.com/build_2016_azure_day-2/

ISAOの役割は?

ISAOは、BizSparkと「くらまね」でスタートアップ企業を応援しています!

ISAOは、マイクロソフト社のスタートアップ支援プログラム「BizSpar Network Partner」としてBizSparkプログラムをご提供するとともに、クラウドの24時間365日運用支援サービス『くらまね for Azure』より、スタートアップの皆様がが魅力あるサービスの開発に集中していただけるよう支援しています。

イベント当日は「屋台スポンサー」として、ドリンクやお菓子を提供させて頂きます。是非お立ち寄り下さい(屋台はAndecoさんのソリューションにご助力頂きました!ありがとうございます)。

本業は、「くらまね」と銘打って、Microsoft Azure をはじめとする各種クラウドの構築や運用、ライセンス提供などを商売として行っています。

ISAOのスタートアップ応援プログラム

これまでもISAOではBizSparkプログラムのご提供を通じたスタートアップの支援を行ってきましたが、新たに「BizSpark Tech Partner」として認定されたことで、技術面でのサポートもより充実させてまいります。

build 2016 落ち穂拾い 〜Azure編 Day 3〜

...こんにちは、Azure担当の原です。 build 2016 で気になったセッションAzure編、最終日のDay 3 です。

Day 3

最終日、今日は15時までで基調講演もありません。

HoloLens体験コーナー

この夏JPLで公開予定の「Destination Mars」が体験できるブースがありました。 が、9時過ぎに並びに行ったものの間に合わず。後で聞いたところによると、相当早い時間から並んでいたようです。

【Building Collaborative Educational Experience in HoloLens】

https://channel9.msdn.com/Events/Build/2016/T703-R3

リンクは張ったもののビデオは公開されていませんでした。残念。 Unityを使って複数のHoloLens間で協調動作するアプリの作り方を説明していました。Unity万能ですね。 どれか1台のHoloLensがサーバーとなって、サーバー・クライアントモデルで同期動作するそうです。

【Azure Data Lake and Azure Data Warehouse: Applying Modern Practices to Your App】

https://channel9.msdn.com/Events/Build/2016/B813

Azure Data Lake と Azure Data Warehouse を上手に使って、モダンなアーキテクチャで大規模データの分析を行いましょう、というお話しでした。 「Ingestion」「Staging」「Processing」「Serving」の4ステージに分類して、それぞれのステージでどんなアプローチが適しているのかという話で、Azureの機能説明というよりは大規模データをどう扱えば良いかという一般論が中心でした。

【Building Hyper-Scale Web and Mobile Apps with Azure App Service】

build 2016 落ち穂拾い 〜Azure編 Day 2〜

...こんにちは、Azure担当の原です。 build 2016 で気になったセッションAzure編、Day 2 にまいります。

Day 2

キーノートは割愛。

【ランチ】

ポテトサラダにポテチが付いてくるという謎な構成。これがbuildか…

【Delivering Applications at Scale with DocumentDB, Azure’s NoSQL Document Database】

https://channel9.msdn.com/Events/Build/2016/B840

ほんとのセッション名は「Spartans, zombies and building for planet scale」だったものの大人の事情でNGだったそうで。 今回いろいろとエンハンスされたDocumentDBのお話しでした。 HALO5 や WALKING DEAD といった実際のゲームに利用した際のパフォーマンスデータも発表されていました。10億リクエスト/日に対して99%のクエリは10ms以下で応答していたとのこと。しっかりスケールしてますね。 これまでちょっと取っつきづらい印象のDocumentDBでしたが、インタフェースがMongoDB互換になったり、Partitioned Collections や Global Database が発表されたりと、面白くなってきました。

おやつ登場

リンゴとバナナとナッツとチーズ。これはおいしい。

【Overview of the MyDriving An Azure IoT and Mobile Suite】

build 2016 落ち穂拾い 〜Azure編 Day 1〜

...こんにちは、Azure担当の原です。

build では数多くの発表がありましたが、まずはAzure関連から。 現地で参加したセッションの中から、特に気になったものを中心にご紹介していきます。

尚、セッションの動画や資料は「Channel 9」で公開されています。buildの3日間だけでも大量のセッションがありましたので、参加しきれなかったものはこれから見ていこうと思ってます。

https://channel9.msdn.com/Events/Build/2016

全体的な感想

基調講演にもありましたが、Azureに関する今年のキーワードは「Choice + Flexibility」「Productivity」「Enterprise Ready」だったようです。 特にインフラ系のセッションでは「Hyper-Scale」という単語が良く出てきていました。イベント中にGAの発表があった Service Fabric なんかが象徴的ですが、より大規模なアプリケーションを支える基盤を柔軟に使えるというアピールですね。

Day 1

【A Lap Around Azure’s Open Source Driven Innovation, Part I: Shipping Penguins in the Cloud | Build 2016 | Channel 9】

https://channel9.msdn.com/Events/Build/2016/B801

Open Source のいろんなソリューションがAzure上でも展開されていますよというお話。 * Open API と Swagger * MariaDB Cluster & Maxscale on Azure * Elastic Product Portfolio (Kibana, Elasticsearch, Logstash ES-Hadoop Beats) * DataStax

build 2016 に参加してきました

...はじめまして。Azure担当の原です。

3月29日~4月1日(現地時間)にサンフランシスコで開催されたマイクロソフトの技術者向けカンファレンス「build 2016」に参加してきました。

【Microsoft Build Developer Conference | March 30 – April 1, 2016】 https://build.microsoft.com/

速報的な記事はもう出揃っているかと思いますので、いきなりですが全体を通して感じたことを1つ。 今年の Build を象徴しているなと感じたビデオがこちらです。 【Microsoft Cognitive Services: Seeing AI app (audio description version)】

基調講演1日目の最後に流れたので、ご覧になった方も多いと思います。

今回のBuildで発表された Cognitive Services を使って、目が見えないエンジニアの生活をどのようにサポートしているかの実例を示した動画です。 講演中、サティアCEOが「Is technology empowering people」と何度か言っていたのはこういうことだったんですね。 テクノロジーで何ができるのか、具体論が示されたことで、デベロッパーに対しては「既にある素材でもここまでできるよ」と強く背中を押された気がします。 長丁場も終わりにさしかかって緩みかけた会場の雰囲気が一変したこの瞬間を現地で過ごせたことが、今回いちばんの収穫だったかもしれません。

今年のbuild、去年のような派手さはありませんでしたが、かつてはビジョンだけだった技術が実際に使えるSDKやAPI、HoloLensのようなデバイスとして登場するなど、確実に推進していく姿勢をはっきりと見せてくれました。それはまた、「フィードバックを求めています」というのが言葉だけで無いこと、動くコードを通じてデベロッパーと対話しようという姿勢なのだと感じられました。

このあたりは、現地を訪れたからこそ強く感じられたことのように思います。

といったような、技術はもちろんですが思わぬ角度からの刺激も受けられた3日間のイベントでした。

▼イベントの主なポイントはこちらをどうぞ。 知っておくべき Build 2016 における発表まとめ【4/4 更新】 | Microsoft Partner Network ブログ https://blogs.technet.microsoft.com/mpn_japan/2016/04/04/build-2016-announcements-summary/

4月1日は入社式&スーツDAY!

...こんにちは!

人事の市橋です。

4月1日の恒例行事

今日は2016年4月1日(金)、 新社会人・新入学の学生の方、おめでとうございます!

ISAOでは、4月1日は毎年恒例スーツDAYです。

普段はほとんどスーツを着ない私たちですが、この日はコスプレ気分でみんなスーツ!

新入社員をお祭り気分で迎え入れました。

2016年度新入社員のご紹介

今年新卒で入社したのは庄司 菫(しょうじ すみれ)さん。

お酒が大好きという彼女は、愛称・スミノフ。

3月に大妻女子大学を卒業。 管理栄養士の資格を持ちながら、IT業界への扉を開いたチャレンジ精神旺盛な一面も。

営業プロジェクト、通称SMAP (Sales&Marketing Project) をメインに活動します!

最後に

本日4月1日、新年度に合わせてISAOのコーポレートサイトもリニューアルしました。

MVS(ミッション・ビジョン・スピリッツ)をサイト自体が体現することにフォーカスしています。

バリフラットモデル、中長期ビジョンのVISION 2020、 ISAOが手がけている自社サービス、クライアントサービスのPortfolioなど、 企画・制作・開発・演出、すべてTeam ISAOの力を集結させて作りました。

是非ご覧ください。 https://www.colorkrew.com/

2016年度のISAOは、世界のシゴトをたのしくを実現するべく、ますます前進していきます。

みなさまよろしくお願いいたします!

SXSW 2016で見つけた、本気で欲しいIoTデバイスTOP5

...前回の記事はこちら SXSW 2016 現地レポート〜基本編〜

こんにちは、ISAO マーケティング担当の中嶋あいみです。

SXSW(サウス・バイ・サウスウエスト)では、 ITパーソンやマーケターなら誰でもワクワクしてしまう新しいプロダクトに出会えます。

実はSXSWで新たに発表されるプロダクトやサービスは一部で、 既にクラウドファンディングのKickstarterやIndiegogoで公開されていたりするものが大半です。

とはいえ、話題のものが一同に集まって、しかも実際に触れることができ、 その場でフィードバックが得られるというのは、出展者にも来場者にも他には無いチャンスです。

Finalist ShowcaseとTradeshowは宝の山

プロダクトにお目にかかれる機会は大きく2つ。

- Interactive Innovation Awards Finalist Showcase

- Tradeshow

Interactive Innovation Awards Finalist Showcase

Interactive Innovation Awards (インタラクティブ イノベーション アワード) は、 SXSWのITセクションの目玉的イベント。

13もの分野から最もイノベーティブなプロダクトやサービスがInteractiveの最終日に表彰されます。

そのファイナリストたち65点を集めたショーケースということで、注目度がかなり高いです。

にも関わらず、 ショーケースは5日間のうちの1日、しかも3時間しかないので、会場はかなりの混雑でした。

確実に見たかったら、オープン前に並びましょう!

Tradeshow(トレードショー)

前回の記事でも触れましたが、大規模かつ種類豊富な展示会です。

日本・韓国・スペイン・ブラジルなど、たくさん出展する国はエリアがまとまっています。

日本は東大の学生らのスタートアップ、Todai to Texasが毎年出展しています。

IoT、流行ってるけど実際使う?

いろんなデバイス・ガジェット・サービスを見ていて、どれも素晴らしいアイデアや技術だと思いますが、

正直、

『面白い!けど・・・使うかな?』

SXSW 2016 現地レポート〜基本編〜

...こんにちは、ISAO マーケティング担当の中嶋あいみです。

私たちは今週、アメリカ・テキサス州・オースティンにいました。

目的はSXSW(サウス・バイ・サウスウエスト)!

今回、ISAOとしては初めてのSXSWに、けいすけ・としき・あいみの3人が行かせていただきました。

SXSW(サウス・バイ・サウスウエスト)とは?

今年で30周年を迎える世界的なカンファレンス。

もともとは音楽フェスティバルから始まり、 今では音楽・映画だけでなくIT業界の見本市・スタートアップの登竜門としても知られています。

日本では知名度が今ひとつですが、 1月にラスベガスで開催されるCES (Consumer Electronics Show) に参加するような企業には、親和性は高いと思います。

業界プロフェッショナルとクリエイターのためのフェスティバルであり見本市でありカンファレンスです。 1987年にミュージックからスタートし、94年には世界に先駆けてインターネットとデジタルのコミュニティを取り込み現在の形に変化してきましたが、その核=COREは常にクリエイター、イノベイターがキャリア広げるために世界中から集い、お互いのアイディアを学び合い、共有しあうためのプラットフォームとして役割を担うことにあります。 年毎に規模が拡大し、今日では10日間でのべ10万人、約380億円の経済効果をもたらす、世界最大級のビジネスフェスティバルに成長しています。

引用元:http://sxsw.jp/about-sxsw/今年の開催は3月11日(金)〜20日(日)。 全10日間が、以下3つのセクションで構成されています。

- Interactive - Music - Film

私たちが参加したのはIT・Tech系のInteractive(インタラクティブ)。

まだスタートアップだった頃に TwitterやFoursquareが有名になるきっかけとなったのもSXSW。

これから流行るサービスをいち早く目にすることができることに加え、 普段会うことのできない世界の著名人の講演に参加できることも魅力です。

2016年のSXSW、目玉は?

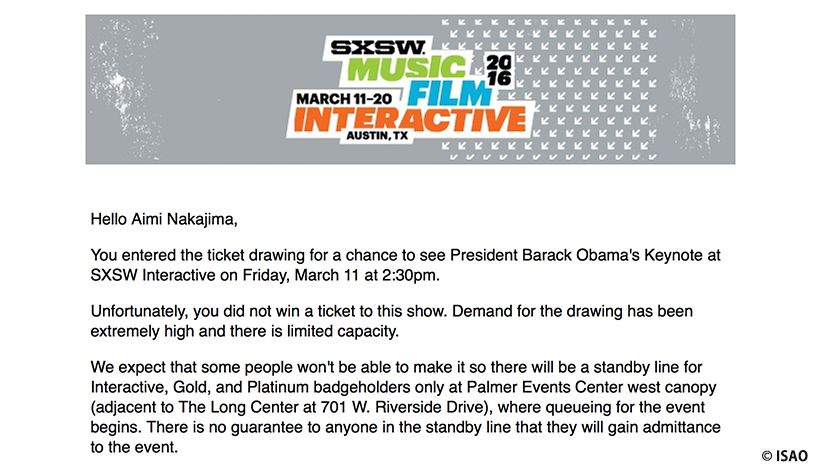

出発1週間前に公式メルマガから驚きのニュースが。

なんと初日のKeynote(基調講演)にオバマ大統領が登壇!

時はアメリカ大統領選の予備選挙真っ只中。 現職の大統領を見られるなんて、おそらく一生に一回のチャンスでしょう。

SXSWは基本的にワークショップ以外は全て予約はできず 人気の講演は当日に並ぶしかないのですが さすがにオバマ大統領は人が殺到してしまうので抽選制でした。

残念ながら抽選には外れてしまい、画面でのパブリックビューイング。

ちなみに、別日にはミシェル夫人も登壇されていました。

帰国日だったので、残念ながらこちらも拝見できず。

SXSWのプログラム

Interactiveは主にこのような構成です。

- Session (セッション)

- Pitch Events (ピッチ)

- Meet Ups (ミートアップ)

- Workshops (ワークショップ)

- Keynotes (基調講演)

- Tradeshow (トレードショー)

- Lounge (特設ラウンジ)

- Party (パーティー)

Session (セッション)

セッションの中でも、登壇する人数で分かれています。

Be Professional〜プロフェッショナルになる~

...プロフェッショナル化と市場価値の関係

会社、組織には、様々な職種の人がいます。

技術系、営業系、管理系、事業系など。

ですが**「プロフェッショナル」**であることに関して、あまり職種とは関係なく意識しなければならないことがあります。

そして、どの職種であっても**「プロフェッショナル」であることが自分自身の市場価値を高めること**に密接に結びついています。

プロフェショナルとは何か

では「プロフェッショナル」とは何か。

会社やチームが行っている「事業」に、尖った専門性を持って貢献すること。

この一点です。

どのように貢献するかは職種によって違いますが、自分の仕事がどういうルートでどのようにチームと事業に貢献しているかを考えることがまずは第一歩です。

そのためには、まず収益を含めてビジネス概観を知る必要があります。 そして、そのビジネスがどんな構造で成り立っているかを知る。

その構造の中で、自分の仕事はどこにどのように、どんなインパクトを与えているか、これを考える。

技術力が高い

交渉がうまい

事務作業がはやい

これらはそれそのものが評価されるべきものではありません。

その高い技術力、そのうまい交渉、その素早い事務作業、これらがチームや事業によい影響を与えている事が、その人の価値と言えるのです。

視点を上げて、専門性を高める

視点を高くしてチーム全体の仕事を考えていきながら、自分の専門分野を高めていく

これがプロフェッショナルへとつながる考え方、キャリアを作る第一歩になるのです。

いつも上機嫌のススメ

...上機嫌、していますか?

いきなりですが、みなさんはいつも上機嫌でしょうか?

ISAOリーダー訓の1つ目に挙げているように

「上機嫌」であることはリーダーに限らずビジネスパーソンの**”スキル”**として非常に大切だと考えています。ISAOリーダー訓

- いつも上機嫌

- メンバーの成長に執念を燃やすこと

- 成長の為に変革を恐れないこと

- 思考停止しない

- 明るく、ポジティブ

- サボらない、率先垂範

- クリーンであること

- 厳しく、やさしいこと

- 常に高い視点で判断する

- できない理由ではなく、できる方法を考える

- 作業に埋もれない

- 毎日組織を前進させる

- 間違ったら素直に認め、すぐ修整

- 業績向上に執念を燃やす

- 起こったことは全て自分の責任とする覚悟を持つ

- 手柄はメンバーやチームのもの、のメンタリティ

- ISAO全体のことを常に考える

- 常に短期、中期、長期のビジョンを持って行動する

- 「いつも上機嫌でなんかいられるか」

- 「なぜ上機嫌でなければいけないんだ」

なんていう意見もあるとは思います。

でも、ボクは「上機嫌でいること」というのはISAOの中で理屈抜きにとても大切にしていきたいし、そういう人を評価もしていきたいと思っています。

上機嫌がうみだすポジティブなスパイラル

上機嫌は周りのメンバーの笑いを作り出す。

笑いがあればいい雰囲気になる。

ポジティブになる。

どんどんチャレンジしたくなる。

ポジティブ、チャレンジ、笑い・・これらは僕がISAOの中で追求し続けたいものなのです。

リーダーこそ、上機嫌

特に、リーダーは**”いつも”**上機嫌であることは重要。

なぜならば、リーダーは不機嫌なメンバーに対して注意をすることは可能ですが、リーダーに周りのメンバーが注意することは難しいからです。

自分がリーダーで「もしかして不機嫌なこと、あるかも」と思った人、どうしたら上機嫌になれるか考えてみましょう。

楽しいから笑うのではない。笑うから楽しいのだ

これは、アメリカの心理学者ウィリアム・ジェームス氏の言葉だそうですが、要は努力することで上機嫌になれるんだ、ということだと理解できます。

どんな上機嫌を目指すのか

それはただニコニコしているという受身の上機嫌ではなく、

周りの人とどんどん関わり、どんどん一緒に熱中していく、という能動的な上機嫌。周りの人と楽しく関わっていく為には、ジョークを言える能力も含めたコミュニケーションスキルがとても重要で、これは意識してスキルアップしていくべきものです。

ここで誤解して欲しくないのは「能弁でなくてはならない」ということではない、ということです。

言葉が少なくても上機嫌なコミュニケーションができればいいのです。

上機嫌な人には人が集まってくる。情報も集まってくる。相談もされる。

なぜなら、みんな楽しく仕事をしたいから。

そうやってみんなの中心になれる人はより大きな素晴らしい仕事ができるステージが用意される。

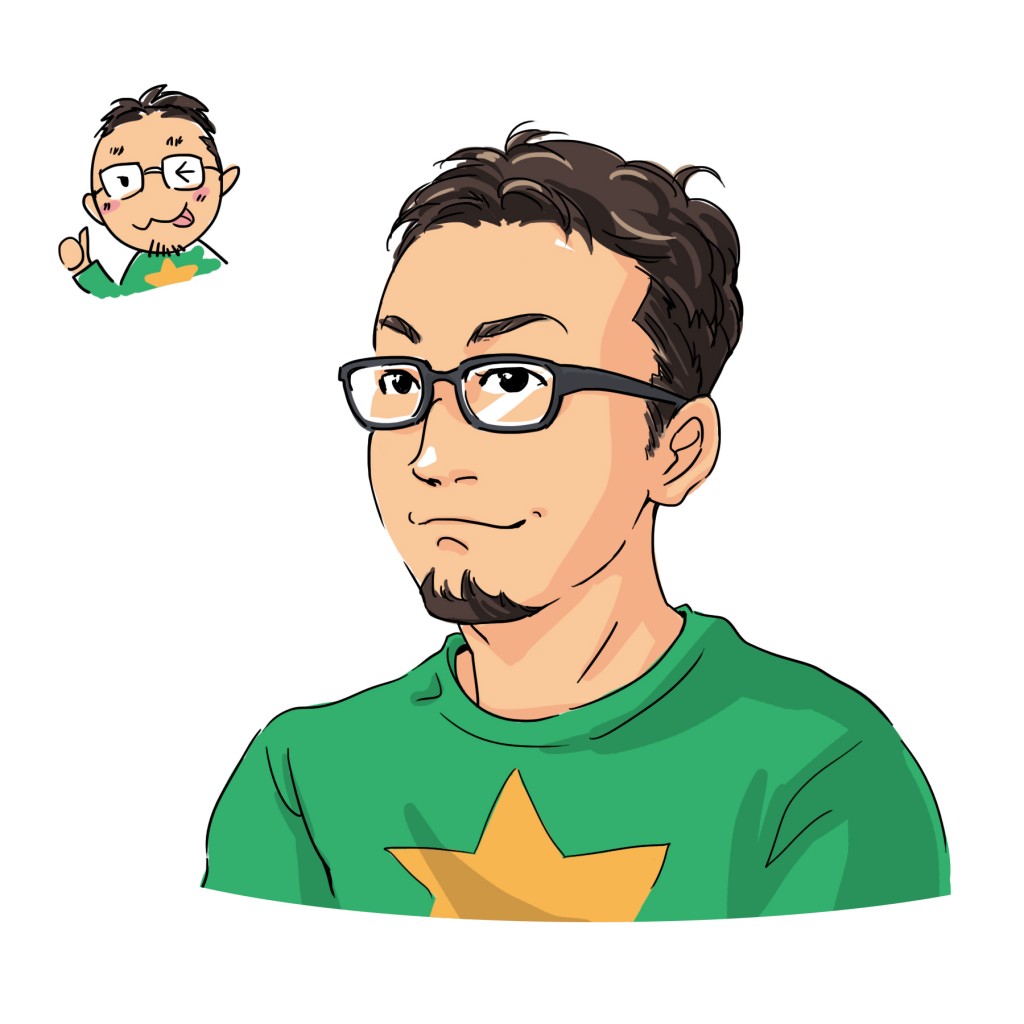

イラスト入り名刺、できました

...全社員イラスト化プロジェクト

こんにちは、ISAO PR担当の中嶋です。

先日、ISAOの新しい名刺が完成しました!

デフォルメバージョンも。

**『全社員イラスト化プロジェクト』**を立ち上げて、1人ひとり描き下ろしています。

イラスト名刺作成のステップ

手書きのラフから・・・

線画にして・・・

色をつけて完成!

イラスト名刺への想い

初めてお会いする方に、顔を覚えてもらえるように・・・との想いで、 総勢7名のISAOクリエイターたちが自主的に立ち上げたチャレンジプロジェクト!

最近、名刺交換が楽しみになりました。

全社員イラスト化まであと100人近くいますが、全員揃うのを心待ちにしています!